A/B-Tests & multivariate Tests

A/B-Tests und multivariate Tests zählen zu den wichtigsten quantitativen Verfahren in der UX-Forschung und Conversion-Optimierung. Sie ermöglichen es, datenbasiert herauszufinden, welche Variante einer Benutzeroberfläche bei realen Nutzer:innen besser funktioniert – sei es in Bezug auf Klickverhalten, Abschlussraten oder Verweildauer. Besonders im digitalen Produktumfeld sind diese Verfahren weit verbreitet, da sie schnell, skalierbar und relativ einfach umzusetzen sind.

Was ist ein A/B-Test?

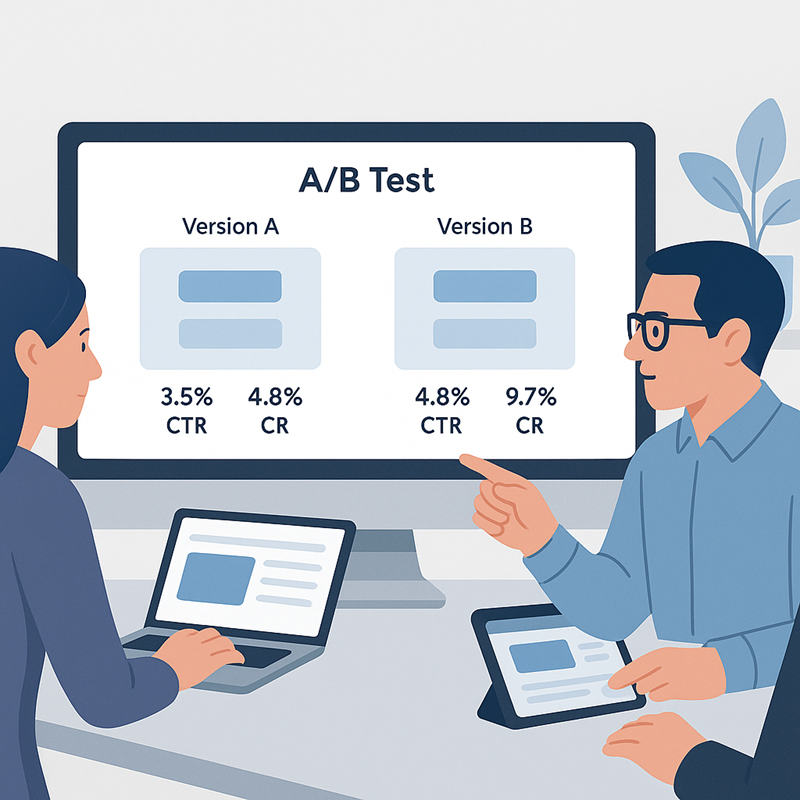

Beim A/B-Test wird eine digitale Komponente – beispielsweise ein Call-to-Action-Button – in zwei Varianten erstellt: Version A stellt die Ausgangslösung dar, Version B enthält eine gezielte Veränderung, etwa eine andere Farbe oder Formulierung. Die Varianten werden anschließend zufällig an verschiedene Nutzergruppen ausgespielt, sodass ihre Wirkung im realen Nutzungskontext gemessen werden kann.

Ein typisches Beispiel aus der Praxis: Ein E-Commerce-Shop testet zwei Varianten seiner Produktseite. In Version A befindet sich der „In den Warenkorb“-Button unterhalb der Produktbeschreibung, in Version B ist er weiter oben und stärker hervorgehoben. Nach zwei Wochen zeigt sich, dass Version B eine um 12 % höhere Conversion Rate erzielt – ein klarer Hinweis auf den positiven Effekt der Positionierung.

A/B-Tests lassen sich nicht nur auf visuelle Elemente anwenden, sondern auch auf sprachliche Formulierungen, Abläufe oder Navigationselemente. Wichtig ist, dass jeweils nur ein Element variiert wird, damit die Ursache für mögliche Unterschiede eindeutig identifizierbar bleibt.

Was ist ein multivariater Test?

Multivariate Tests gehen einen Schritt weiter: Statt nur eine einzelne Variable zu verändern, werden mehrere Elemente gleichzeitig getestet – etwa die Kombination aus Buttonfarbe, Überschrift und Bildauswahl. Dadurch entsteht eine Vielzahl an möglichen Kombinationen, die parallel ausgespielt werden.

Ein Beispiel: Eine Landingpage soll optimiert werden. Variante 1 kombiniert einen grünen Button mit einer kurzen Überschrift und einem neutralen Bild. Variante 2 zeigt einen blauen Button, eine ausführlichere Headline und ein emotionaleres Bildmotiv. Mithilfe eines multivariaten Tests lässt sich nicht nur herausfinden, welche Variante insgesamt besser abschneidet, sondern auch, welche spezifische Kombination von Gestaltungselementen besonders effektiv ist.

Allerdings steigen mit der Anzahl der getesteten Variablen auch die Anforderungen an den Traffic – denn nur mit ausreichend vielen Nutzer:innen lassen sich belastbare Aussagen treffen.

Wann sind solche Tests sinnvoll?

A/B- und multivariate Tests sind besonders dann sinnvoll, wenn es darum geht, bestehende Interfaces iterativ zu optimieren. Sie eignen sich hervorragend zur Beantwortung von Fragen wie: „Funktioniert die neue Button-Beschriftung besser?“ oder „Wird der neue Checkout-Prozess seltener abgebrochen?“.

Voraussetzung ist, dass bereits eine gewisse Anzahl an Nutzer:innen vorhanden ist, damit die Ergebnisse statistisch aussagekräftig sind. Zudem sollten klare Erfolgsmetriken vorliegen – etwa Klickrate, Conversion, Absprungrate oder die Anzahl abgeschlossener Formulare.

Weniger geeignet sind A/B-Tests in sehr frühen Designphasen, wenn es noch keine funktionierenden Interfaces oder keine klare Zieldefinition gibt.

Vorteile aus UX-Sicht

Ein zentraler Vorteil von A/B-Tests liegt in ihrer Objektivität: Statt über Designfragen zu spekulieren, liefern sie empirische Daten zur tatsächlichen Wirksamkeit einzelner Varianten. Auch kleine Änderungen können schnell evaluiert werden – etwa die Änderung einer Icon-Farbe oder die Platzierung eines Labels. Besonders in agilen Teams mit kontinuierlichem Deployment gehören solche Tests heute zum Standardrepertoire.

Da viele Tools bereits automatische Auswertung und Segmentierung anbieten, lassen sich Ergebnisse effizient analysieren – inklusive Konfidenzintervallen und Signifikanztests.

Herausforderungen und Grenzen

So nützlich A/B-Tests sind – sie haben auch ihre Schwächen. Zum einen liefern sie keine Erklärung für beobachtete Effekte. Wenn beispielsweise eine Variante schlechter performt, bleibt offen, ob es an der Farbe, dem Text oder dem Kontext liegt. Daher ist es sinnvoll, quantitative Tests mit qualitativen Methoden wie Interviews oder Beobachtungen zu kombinieren.

Ein weiteres Problem: Bei zu kleinen Stichproben können Zufallseffekte zu falschen Schlüssen führen. Auch der sogenannte „Winner’s Curse“ – das Überschätzen positiver Ergebnisse – ist ein bekanntes Phänomen. Deshalb sollten Tests gut geplant, ausreichend lange durchgeführt und kritisch ausgewertet werden.

Zudem besteht die Gefahr, sich auf kurzfristige Gewinne zu fokussieren (etwa höhere Klickraten), ohne die langfristige Nutzerbindung oder UX-Qualität zu berücksichtigen.

Tools in der Praxis

In der Praxis kommen zahlreiche Tools zum Einsatz, um A/B- und multivariate Tests durchzuführen. Bekannte Plattformen wie Optimizely, VWO oder Adobe Target bieten umfassende Möglichkeiten zur Testgestaltung, Segmentierung und Auswertung. Für einfachere Use Cases genügen bereits Tools wie UsabilityHub oder Google Optimize (letzteres wurde inzwischen eingestellt). Wer besonderen Wert auf Datenschutz legt, findet Alternativen wie Matomo oder Piwik PRO.

Die Auswahl des richtigen Tools hängt stark von Zielsetzung, technischer Infrastruktur und Ressourcen ab – und sollte immer auch datenschutzrechtlich geprüft werden.

Fazit

A/B-Tests und multivariate Tests sind leistungsstarke Instrumente der UX-Optimierung, die helfen, Designentscheidungen datenbasiert abzusichern. Besonders dort, wo es auf Conversion, Effizienz und Nutzungsintensität ankommt, sind sie unverzichtbar. Entscheidend ist jedoch ein reflektierter Einsatz – idealerweise nicht isoliert, sondern im Rahmen eines ganzheitlichen, nutzerzentrierten Entwicklungsprozesses.

Forschung zu A/B-Testing im UX- und Usability-Kontext

Diese Arbeiten untersuchen den methodischen Einsatz von A/B-Tests zur Bewertung und Optimierung der User Experience sowie deren Integration in digitale Entwicklungsprozesse.

User Experience Evaluation through Automatic A/B Testing

Verknüpft A/B-Tests mit maschinellem Lernen zur automatisierten UX-Bewertung im realen Nutzungskontext.

Gardey, J. C., & Garrido, A. (2020). User experience evaluation through automatic A/B testing. In Intelligent User Interfaces. https://doi.org/10.1145/3379336.3381514

Features of A/B Testing of a Delivery App

Vergleicht A/B-Testing mit Usability-Testing und zeigt deren Einsatz im App-Design mit Fokus auf UX-Optimierung.

Khitskova, Y., Asnina, N., Efimova, O. E., & Makovy, K. (2024). Features of A/B testing of a delivery app. IEEE Proceedings. https://doi.org/10.1109/summa64428.2024.10803747

Bridging Quantitative and Qualitative Digital Experience Testing

Stellt ein integriertes Framework vor, das A/B-Testing mit qualitativen UX-Methoden kombiniert, um Nutzerverhalten tiefgehend zu analysieren.

Kumar, R. (2023). Bridging quantitative and qualitative digital experience testing. In ACM SIGIR. https://doi.org/10.1145/3539618.3591873